Entendiendo las APIs de Inferencia: Qué Son y Por Qué Son Importantes en la IA

Una API de inferencia permite a los desarrolladores enviar datos (en cualquier protocolo, como HTTP, gRPC, Kafka, etc.) a un servidor con un modelo de aprendizaje automático implementado y recibir las predicciones o clasificaciones como resultado.

Prácticamente, cada vez que accedes a modelos en la nube como OpenAI o Gemini o modelos implementados localmente usando ollama, lo haces a través de su API de inferencia.

Aunque hoy en día es común usar grandes modelos entrenados por grandes corporaciones como Google, IBM o Meta, principalmente para fines de LLM, es posible que necesites usar pequeños modelos entrenados a medida para resolver un problema específico para tu negocio.

Por lo general, estos modelos son desarrollados por los científicos de datos de tu organización y debes desarrollar algún código para inferirlos.

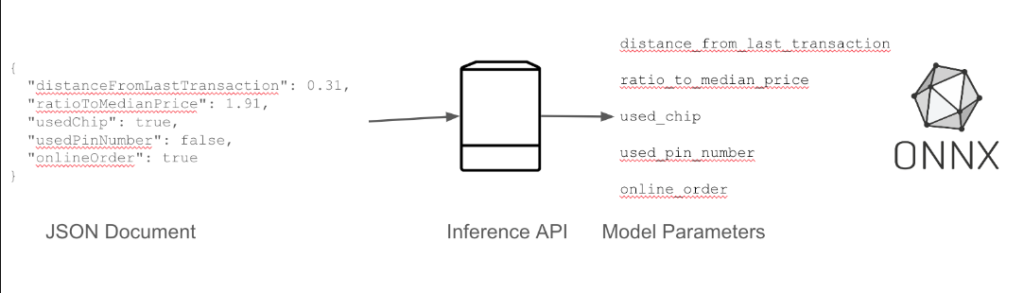

Echemos un vistazo al siguiente ejemplo:

Supongamos que estás trabajando para un banco y los científicos de datos han entrenado un modelo personalizado para detectar si una transacción con tarjeta de crédito puede considerarse un fraude.

Es importante mencionar que se necesita exportar el modelo a un formato ONXX (aka mas detalles Explorando el Estándar ONNX: Abriendo las Puertas a la Interoperabilidad en Redes Neuronales – #telodijoelbuga )

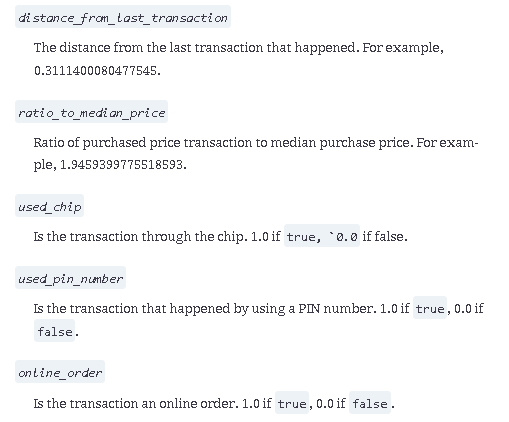

atributos de entrada modelo ONNX

parámetros de salida del modelo:

Algunas cosas que puede notar aquí son:

Todo es un valor flotante, incluso cuando se hace referencia a un valor booleano como en el campo used_chip.

El resultado es una probabilidad, pero desde el punto de vista comercial, desea saber si ha habido fraude.

Los desarrolladores prefieren usar clases en lugar de parámetros individuales.

Este es un caso de uso típico para crear una API de inferencia para el modelo para agregar una capa de abstracción que facilite el consumo del modelo.

Las ventajas de tener una API de inferencia son:

Los modelos son fácilmente escalables. El modelo tiene una API estándar y, debido a la naturaleza sin estado de los modelos, puede escalar hacia arriba y hacia abajo como cualquier otra aplicación de su cartera.

Los modelos son fáciles de integrar con cualquier servicio, ya que ofrecen una API conocida (REST, Kafka, gRPC, …)

Ofrece una capa de abstracción para agregar funciones como seguridad, monitoreo, registro, …